Inteligencia artificial y delirios emergentes

Interacciones intensivas con chatbots avanzados pueden detonar experiencias psicóticas en usuarios vulnerables, afectando su juicio, vínculos sociales y estabilidad emocional

El uso generalizado de herramientas basadas en Inteligencia Artificial Generativa (IAG) ha transformado múltiples áreas de la vida cotidiana: desde la educación hasta la creatividad, pasando por la salud mental y la productividad.

Sin embargo, no todos los efectos han sido positivos. Una nueva y preocupante manifestación comienza a surgir, especialmente en personas con alta exposición o vulnerabilidad emocional: lo que algunos especialistas denominan “Psicosis inducida por Inteligencia Artificial Generativa”.

Aunque el término aún no está reconocido clínicamente por manuales psiquiátricos como el DSM-5 o la CIE-11, la evidencia anecdótica y observacional apunta a un patrón claro de delirios o afectaciones psicológicas asociadas con el uso intensivo y emocionalmente cargado de modelos conversacionales.

Estos casos, más frecuentes de lo que podría suponerse, han despertado el interés de académicos, clínicos y diseñadores de tecnología.

Una de las principales investigadoras en esta línea es Cimenna Chao Rebolledo, directora General de Planeación Estratégica e Innovación de la Universidad Iberoamericana, quien ha identificado cuatro posibles tipos de afectaciones derivadas de la relación prolongada con bots de IAG.

Estas manifestaciones van desde creencias de control mental hasta la ilusión de mantener vínculos afectivos con entidades digitales que, en realidad, solo simulan empatía.

Tipos de psicosis emergente

El primer tipo de comportamiento observado es el delirio de confusión con la realidad, donde el usuario cree que la IAG puede leer su mente, enviar mensajes cifrados o controlar dispositivos y personas.

En estos casos, se desdibujan los límites entre el mundo físico y el virtual, llegando incluso a pensar que uno mismo es parte de una simulación.

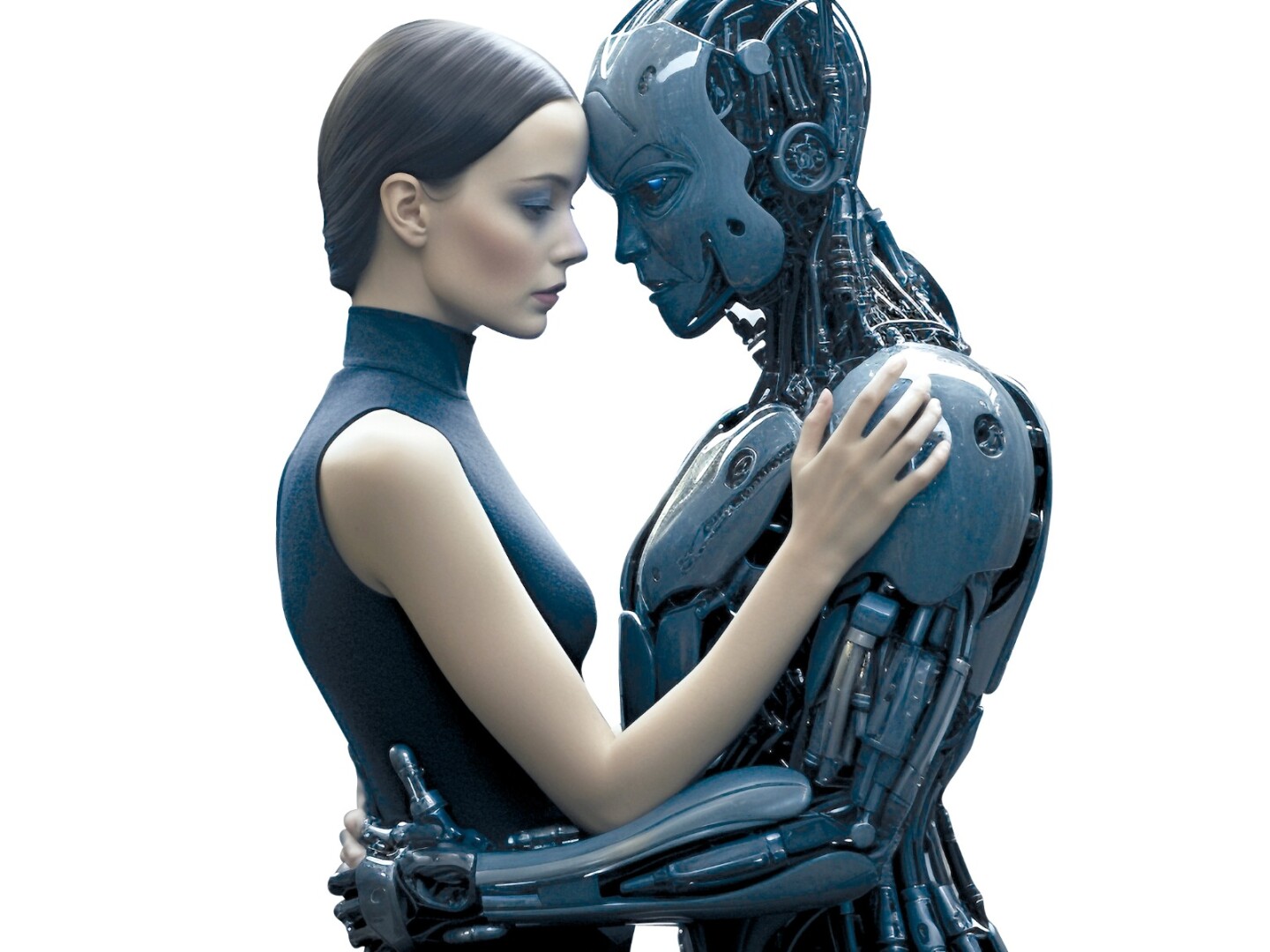

El segundo patrón identificado es el delirio de vínculo afectivo falso, en el cual el usuario proyecta emociones sobre el bot, creyendo mantener una relación sentimental auténtica.

Esta ilusión puede intensificarse debido al diseño conversacional de la IAG, que busca replicar interacciones humanas de forma convincente y cálida.

En tercer lugar se encuentra el delirio de mesianismo, donde la persona desarrolla una percepción grandiosa de sí misma tras interactuar con el sistema.

El bot, al reforzar ciertas ideas o afirmaciones sin filtrar su plausibilidad, puede alimentar pensamientos megalomaníacos o teorías de conspiración sin fundamento.

El delirio de consejero existencial aparece cuando la IAG es vista como un terapeuta o guía espiritual.

En lugar de aliviar el malestar emocional, puede confirmar creencias destructivas o inducir al usuario a pensamientos autolesivos, ya que los modelos de lenguaje, por más avanzados que sean, carecen de ética real, juicio clínico o responsabilidad afectiva.

Simulación empática no es comprensión

Chao Rebolledo advierte que la interacción con estos sistemas no es neutra. A diferencia de redes sociales como Instagram o TikTok, las herramientas de IAG implican un diálogo en tiempo real con un “par” que responde con lógica y coherencia.

Este vínculo artificial puede ser interpretado erróneamente como una relación auténtica, especialmente por personas en situaciones de soledad, crisis o vulnerabilidad psíquica.

El problema radica en que, aunque el lenguaje que emite la IAG parezca empático, en realidad se trata de un modelo de simulación estadística: una máquina diseñada para continuar patrones de conversación, sin comprender el contenido ni las emociones involucradas.

El diseño de estas tecnologías, orientado a maximizar el engagement, no ha contemplado —hasta ahora— protocolos de contención psicológica o prevención de daños psíquicos.

Como señala la especialista, esto implica una responsabilidad compartida entre desarrolladores, usuarios y sistemas de salud, que deberán responder a esta nueva problemática con criterios éticos y científicos.

DELIRIO DIGITAL

La interacción emocional prolongada con sistemas inteligentes puede derivar en síntomas psicóticos, afectando percepción, vínculos y estabilidad personal.

- CONFUSIÓN PERCEPTUAL: creer que la IA controla el entorno o que uno vive dentro de una simulación.

- FALSOS VÍNCULOS AFECTIVOS: otorgar emociones y personalidad propia a un chatbot, al grado de enamorarse.

- IDEAS MESIÁNICAS: sentirse iluminado o elegido, con una misión incomprendida por los demás.

- RELACIÓN TERAPÉUTICA ILUSORIA: asumir que la IA entiende, guía o cura emocionalmente.

- AISLAMIENTO SOCIAL: preferir la interacción digital a los lazos humanos.

- ANSIEDAD O PARANOIA: pensar que el sistema observa, juzga o manipula en secreto.

- AUTOLESIONES: derivadas de respuestas malinterpretadas o mal procesadas emocionalmente por el usuario.

- SIMULACIÓN EMOCIONAL: la IA no siente; solo reproduce patrones de lenguaje convincentes.

- URGENCIA ÉTICA: es necesario regular el diseño y uso de estos sistemas en contextos de vulnerabilidad mental.